Das Jahr 2017 ist schon ein paar Tage alt und der 33. Chaos Communication Congress ist bereits seit einer Woche Geschichte. Mit etwas Abstand möchte ich meine Eindrücke zusammenfassen.

Entspanne und genieße

Im Gegensatz zu meinen letzten Besuchen bin ich dieses Mal etwas anders vorgegangen. Während des Kongresses habe ich so gut wie nichts veröffentlicht; Nicht auf meinem Blog und auch auf Facebook nur ein paar Bilder. Ich habe auch nicht so viele Veranstaltungen besucht, sondern mich eher entspannt treiben lassen. Der Kongress ist mit seinen 12.000 Besuchern derart groß und wuselig, dass man mit Gelassenheit viel weiter kommt, als wenn man ständig zwischen den Säälen hin und her rennt. Einige interessante Vorträge habe ich mir erst später in Ruhe zu Hause angesehen. So konnte ich in Ruhe das tolle, bunte, lustige, anregende Ambiente genießen.

33C3 Dekoration

33C3 Hackcenter

33C3 – 3D Drucker en masse

33C3 Partyzone

Traditionsgemäß waren auch diesmal wieder die ganzen Zwischengeschosse und Aufenthaltsbereiche bunt und fantasievoll dekoriert. Mal im Stil eines englischen Salons, mal sind es Beduinenzelte, dann wiederum feinstes 70er Jahre Kunststoffblasen Ambiente á la Barbarella. Die Assemblies und das Hackcenter lagen wie immer im halbdunkel, was die ganzen Spielereien mit LEDs, Projektoren und Elektrolumineszentbändern richtig zur Geltung kommen ließ. In der großen Halle war wie in den Vorjahren wieder eine clubmäßige Partyzone. Die riesigen Installationen erinnerten diesmal an Tetris und Minecraft und es wurde bereits am frühen Abend feinster chilliger Elektrobeat gespielt.

33C3 Organisation

Die Organisation ist mittlerweile unfassbar gut eingespielt. Es wurde an tausend Details gedacht, ein eigenes Telefonnetz installiert und das WLAN war immer gut. Das ist um so bemerkenswerter, weil die ganze Arbeit von Freiwilligen (Engeln) gemacht wird. In diesem Jahr hatten sich sage und schreibe 2.500 Leute dafür gemeldet – mehr als benötigt wurden.

Natürlich wimmelte es auch wieder von kleinen Späßchen: Am Eingang der Toiletten hingen Zettel, die den WLAN-Empfang mit 0-5 Sternen bewerteten, ich habe ein Wettrennen zwischen zwei Jungs auf einem rollenden grünen Cordsessel und einer Matekiste gesehen, eine Polonaise von 15 Leuten auf Hoverboards und noch viele andere lustige Sachen.

Vorsicht: CYBER!

Der Running-Gag der Veranstaltung war aber der Begriff Cyber. Ein Begriff, den seit Ende der 70er Jahre eigentlich keiner mehr benutzt, aber in letzter Zeit von Leuten, die überhaupt kein Fachwissen haben, für ihre politische Propaganda genutzt.

Folgerichtig wurde mit zwinkerndem Auge alles, was irgendwie „gefährlich“ war mit gelbem Cyber-Absperrband gekennzeichnet: Von fiktiven Tatorten über Laptops, bis zu den Besuchern selber, die sich die Bänder auf ihre Klamotten geklebt haben.

33C3 – Vorsicht: Cyber!

Auch diesmal gab es natürlich wieder sehr viele spannende Vorträge mit Themen irgendwo zwischen Politik, tollen Basteleien und Raumfahrt. Einige waren lustig (wie baue ich einen Flipper selber) und einige wiederum extrem ernst (wie tötet man Menschen aus tausenden Kilometer Entfernung mit einer Drohne, wenn man nur ihre Telefonnummer hat).

Für mich waren in diesem die folgenden Schwerpunkte wichtig:

- Messenger

- Vertrauenswürdige Hardware

- Datenanalyse

Messenger

Messenger sind in den letzten Jahren ein großes Ding geworden. Ich habe so einen seltsamen Walled-Garden-Zwitter zwischen E-Mail und SMS zwar nie vermisst, aber zu meiner Verblüffung haben sich die breiten Massen auf WhatsApp und Co gestürzt und man wird mittlerweile dumm angeguckt, wenn man so etwas nicht hat. Also muss man sich wohl damit beschäftigen. Aus diversen Gründen halte ich zur Zeit keinen einzigen Messenger für gut, aber ich bin ja lernwillig. Also habe ich mir zwei Veranstaltungen angesehen.

In einem kleineren Workshop Raum fanden sich ca. 100 Zuhörer ein, um einen Vergleich der folgenden Messenger zu hören: WhatsApp, Signal, Viber, Threema, Wire, Kontalk, Facebook Messenger, Telegram, Allo und Skype. Alleine die Vielfalt zeigt schon ein Grundproblem aller Angebote: Sie sind abgeschottet. Keiner kann mit dem anderen kommunizieren, wenn der ein anderes System nutzt.

In dem Vortrag ging es nur um einen kleinen, aber wichtigen Teilaspekt: Die Sicherheit. Der Laie hört nur „WhatsApp ist ja verschlüsselt“ und damit ist alles gut. Leider ist die Realität nicht so einfach. Um es kurz zu machen:

Es gab keine Lösung, die als wirklich sicher und vertrauenswürdig einzustufen ist. Skype ist bereits in der Vorrunde mangels End-to-end Verschlüsselung ausgeschieden, Threema konnte sich als „vermutlich sicher, aber nicht völlig vertrauenwürdig“ noch relativ gut behaupten.

Threema war auch Untersuchungsgegenstand der Vortrags „A look into the Mobile Messaging Black Box“ von Rolan Schilling, der hier zu sehen ist:

Hier wurde der Threema Messenger per reverse-Engeneering untersucht: Die Verschlüsselung selber, das Schlüssel Management und das Kommunikationsprotokoll. Das Fazit ist, dass alles handwerklich sauber zu sein scheint. Das letzte bestehende Problem ist die Vertrauenswürdigkeit des Programms selber. Die Vortragenden ermutigen Threema deshalb, den Source Code des Clients als Open Source freizugeben. Dazu haben sie bereits selber Code auf Github eingestellt, den sie qualitativ als „lediglich akademisch“ eingestuft haben: https://github.com/o3ma

Vertrauenswürdige Hardware

Eine der größten momentanen Herausforderung betreffs der Sicherheit ist aktuell aber, dass es prinzipiell unmöglich ist, sicher über eine Hardware zu kommunizieren, die auf unterster Ebene von Backdoors verseucht ist. Das gilt zur Zeit für alle PC, Router, Smartphones und sonstige Geräte.

Der Vortrag „Virtual Secure Boot“ von Gerd Hoffmann zielte darauf ab, wie man einen PC sicher bootet. Das ist erstaunlicherweise mit sehr viel Aufwand verbunden und kann nur bei sehr wenigen Modellen nachgerüstet werden.

Der Vortrag „Untrusting the CPU“ von Jaseg handelte davon, wie auf einem nicht vertrauenswürdigen Computer sicher und verschlüsselt kommuniziert werden könnte. Der Vorschlag ist im Prinzip ein Gerät, das zwischen die Ein- und Ausgabe gehängt wird. Der Computer bekäme von den verschlüsselten Nachrichten gar nichts mit.

Der Ansatz ist auf technischem Level sehr interessant, aber auf einer höheren Ebene ziemlich am Thema vorbei. Denn die eigentliche Frage ist:

„Wie stelle ich sicher, dass ich einen Rechner ohne Backdoors habe?“

Das kann mit den Standardcomputern, die heutzutage erhältlich sind prinzipiell nicht erreicht werden. Wenn man schon so ein technisch aufwendiges Zwischengerät, wie Jaseg es vorschlägt, herstellen würde – wieso baut man dann nicht stattdessen einen einfachen und sicheren Computer?

Komplexität nicht durch noch komplexere Ansätze ersetzen

Mir ist in letzter Zeit ohnehin aufgefallen, dass es generell eine Neigung gibt, Dinge die aufgrund übergroßer Komplexität unsicher oder unbedienbar werden, durch das Hinzufügen weiterer Elemente zu reparieren. Leider wird das zugrunde liegende Problem dadurch nicht gelöst und die Komplexität steigt weiter.

Als sinnvoller empfinde ich es, eine Sicherheitslücke mit einfachen Mitteln anzugehen. In ihrem Vortrag „Hochsicherheits-Generalschlüssel Marke Eigenbau“ erläutern Michael Weiner und RFGuy über eine Dreiviertelstunde lang, wie sie sich für ein bestimmtes mechanisches Schließsystem einen Generalschlüssel berechnet und angefertigt haben.

Verblüffenderweise weisen sie am Schluss darauf hin, dass das System gut sei, obwohl sie es knacken konnten. Man müsse nur aufpassen, dass die Schlüssel nicht fotografiert werden können und empfehlen daher, die Schlüssel stets in einem Mäppchen zu transportieren.

Datenanalyse

Der Satz „Ich habe doch nichts zu verbergen“ zeugte schon immer von naiver Unwissenheit. Ich habe dann häufig geantwortet „Das kannst Du nicht beurteilen, weil Du nicht weißt wer wann was aus Deinen Daten herausliest.“

Genau hierzu gab es einen wundervollen Beitrag von David Kriesel: „SpiegelMining – Reverse Engineering von Spiegel-Online“, in dem eine Datenanalyse der Veröffentlichungen von Spiegel Online vorgestellt wird. Interessant sind hier bei die Erkenntnisse, die quasi „um die Ecke“ gewonnen wurden. Das sind Dinge, die in den Rohdaten eigentlich gar nicht drinstecken, wie Inhaltepräferenzen der Leser, Kommentartätigkeiten, verändertes gesellschaftliches Bewusstsein und eine Abschätzung, welche Redakteure miteinander ein Verhältnis haben könnten. Absolut sehenswert!

Noch beklemmender, weil es jeden von uns angeht, ist die Datenanalyse im Vortrag „Build your own NSA“ von SVeckert und Andreas Dewes auf der Basis von Webtracking. Aus einem Datensample konnten Personen de-anonymisiert werden. Als die Politikerin Valerie Wilms (MdB, Die Grünen) über die Erkenntnisse zu ihrem Tagesablauf, den Bankverbindungen, Interessen und zur Struktur ihrer Einkommensteuererklärung informiert wurde, meinte sie „Is echt alles zu sehen, ne? Scheisse!“

Fazit

Auch der 33. Chaos Communication Congress hat wieder eine Gefühlsmischung aus Neugier, Ratlosigkeit und Niedergeschlagenheit – aber auch Faszination und einer Menge Spass bei mir hinterlassen. Es war auf jeden Fall eine großartige Veranstaltung.

In diesem Jahr muss sich der CCC jedoch nach einem anderen Veranstaltungsort umsehen, da das Congress Centrum Hamburg saniert und 2019 wiedereröffnet werden soll.

Tickets für einen Hackerkongress kauft man nicht einfach – die muss man sich erarbeiten.

In diesem Jahr möchte ich gerne wieder den Chaos Communication Congress besuchen. Es ist der 33. Kongress, den der Chaos Computer Club seit 1984 veranstaltet. Aus einem gemütlichen Treff von eine paar Nerds ist ein Monster von zuletzt 10.000 Besuchern und Teilnehmern geworden. Weil der Andrang so groß ist, werden die Tickets in diesem Jahr in drei Tranchen verkauft. Die erste wurde am Montag, den 07.11. ab 20:00 verkauft. Weitere Termine sind Sa, 19.11. 15:00 und Fr, 25.11.2016.

Wie zu erwarten war der Andrang groß. So groß, dass die Server schon um 19:55 in die Knie gingen. Der Kauf der Karten hätte eine Sache von dreieinhalb Minuten sein können: Seite aufrufen, Karten in den Warenkorb legen, persönliche Angaben machen, bestätigen, E-Mail Bestätigung mit Referenznummer bekommen.

Das Positive vorneweg: Ich habe es geschafft.

Allerdings hat der ganze Prozess satte 42(!) Minuten gedauert. Zwischendurch habe ich geflucht, dass der Server permanent in die Knie ging und mit Fehlern um sich geworfen hat. Ich dachte: „Hacker sein wollen, aber nicht mal einen Onlineshop Spitzenlastfähig hinbekommen?“

Aber ich lag falsch.

Das ganze war offensichtlich ein Test, ob man auch einer Eintrittkarte würdig ist. Der Ticketshop als raffiniertes Auswahlverfahren. Man hat die Bestellung nämlich nur geschafft, wenn man sich ein bisschen in Webprogrammierung auskennt.

- Zunächst darf man sich nicht von Ladezeiten im Minutenbereich abschrecken lassen

- Vier von 5 Aufrufen endeten in verschiedenen Gateway Errors, 500 Internal Server Errors oder schlicht im Timeout.

- Man sah auch nur das HTML Grundgerüst, weil Stylesheets und Grafiken gar nicht erst nachgeladen wurden. Davon durfte man sich nicht verwirren lassen.

- Als ich nach 29 Minuten endlich soweit war, den Button „Place binding order“ anzuklicken, passierte… nichts!

- Grund dafür war ein Javascript Fehler: „ReferenceError: django is not defined“. Um das zu bemerken, musste man schon mal die Entwicklerwerkzeuge des Browsers benutzen.

- Also schnell noch das Network Profiling anwerfen und die Seite neu laden. Siehe da: Alles wird brav geladen, nur der Request zu /jsi18n/en/ bricht jedesmal mit einerm Code 504 ab.

- Ich schaue mir daraufhin den HTML Code an und stelle fest, dass es sich freundlicherweise um ein normales Webformular handelt und nicht um ein eventgetriebenes Javascript-Ajax-was-weiss-ich-Gedöns handelt. Ich vermute, dass nur ein Event zur Eingabeprüfung auf dem Formular liegt. Javascript abzuschalten sollte reichen.

- Stelle fest, dass man Javascript in Firefox gar nicht mehr offiziell abschalten kann. Das geht nur noch über die Spezial-URL about:config, wenn man weiss dass der gesuchte Key javascript.enabled auf false gesetzt werden muss.

- Danach hat der Button wunderbar funktioniert.

Jetzt habe ich Tickets – ich bin würdig teilzunehmen!

Der Aufstieg der politischen Rechten in vielen westlichen Ländern irritiert und erschreckt. Ich versuche mal auch etwas Positives darin zu sehen: Es wird damit begonnen, über den Status Quo in Gesellschaft und Wirtschaft nachzudenken. Ich meine wirklich nachzudenken. Ich habe jahrelang nicht so viele Analysen und hinterfragende Artikel gelesen, wie im letzten Jahr. Es keimt ein Verständnis für „die Anderen“. Dabei meine ich keinesfalls Rechtsruck oder Anbiederei, sondern wirklich ein Hinterfragen der eigenen Standpunkte, Sichtweisen und Werte. Das ist nämlich höchste Zeit. Mich selber will ich überhaupt nicht ausnehmen.

Parallelgesellschaften

Für mich selbst war der erste Schritt zum Verständnis der Unruhe das Erkennen von Parallelgesellschaften. Dabei meine ich nicht etwa Ali und Fatima, die nach südostanatolischen Riten in Kreuzberg wohnen. Sicher – die gibt es auch, aber ich meine Parallelgesellschaften, die mich selber viel unmittelbarer betreffen.

Ich hatte vor ein paar Jahren, als ich Freunde in San Francisco besuchte, drei echte Aha-Erlebnisse die ich aber damals noch nicht recht einordnen konnte:

- Auf einer privaten Party in Berkeley wurde ich beim Smalltalk gefragt, in welchem Bereich ich in Deutschland denn so arbeite – CleanTech oder Medien. Wow – von 1000 möglichen Berufsfeldern kamen offensichtlich nur zwei in Frage – und eins war tatsächlich ein Treffer!

- Als ich durch die Cafés im Mission District in San Francisco schlenderte, fiel mir etwas auf; Die Leute um mich herum waren mir angenehm, ich verstand die Dresscodes, hatte eine Idee, wie und an was sie arbeiten und wie sie ticken. Ich kam mir nicht als Tourist und Ausländer vor. Obwohl ich mir sehr klar darüber bin, dass in den USA sehr viele Dinge erheblich anders laufen, als in Deutschland, fühlte ich mich fast wie zu Hause. Ich hatte das Gefühl, mit diesen Leuten mehr Gemeinsamkeiten zu haben, als mit vielen Deutschen aus der Provinz. Gleichzeitig war mir klar, dass dieser Ort zwar geographisch in den USA lag, aber mit Werten, Normen, Zielen und Verdienstmöglichkeiten der amerikanischen Durchschnittsbevölkerung überhaupt nichts zu tun hat.

- Auf einer Firmenparty in Downtown San Francisco kam ich mit Softwareentwicklern aus USA, Schottland und Serbien locker ins Gespräch. Irgendwann sprachen wir über die Verständlichkeit der verschiedenen englischen Dialekte, weil die Leute dort aus allen Teilen der Welt zusammenarbeiten. Ich sagte irgendwann, dass ich eigentlich alle so einigermaßen verstehe – nur bei der Autovermietung hätte ich drei mal nachfragen müssen. Darauf wurde locker eingeworfen „ja, aber das waren sicherlich Schwarze“. Darauf meinte ich, dass die Aussage nicht gerade politisch korrekt wäre. Die Antwort saß wie die Faust im Gesicht: „Das stimmt – aber sei ehrlich: Wie viele Schwarze hast Du heute auf der Konferenz gesehen, oder in den Firmen die Du besucht hast? Da sind weiße Amerikaner aus der Mittelschicht, Europäer, Asiaten und ein paar Inder. Alle alle haben studiert. Es gibt so gut wie keine Mexikaner, keine Schwarzen, keinen White Trash“.

Ein weiteres Aha-Erlebnis hatte ich neulich in Berlin. Ich hatte eine Foto-Session, bei der ich systematisch den Bereich um die Marzahner Promenade fotografiert habe.

Marzahn – jener Stadtteil, von dem man in Prenzlauer Berg schon mal abschätzig sagt, dass er „kurz vor Polen liegt“ und das nicht nur geographisch, sondern auch wirtschaftlich meint. Man weiß ja, wie es dahinten zugeht: Platte, Ghetto, Wendeverlierer und Rechtsradikale, no-go Area. Nicht wahr – das weiß man doch.

Quatsch! Gefühltes Wissen. Eigentlich weiß man gar nichts, weil man nie dort ist und auch niemanden kennt, der dort wohnt. Was habe ich also vorgefunden?

- Zunächst mal sehr viel Platz. Breite Straßen, ziemlich viel Grün. Sehr großzügige Fußgängerbereiche zwischen den zehngeschossigen Plattenbauten. Das ist schon mal sehr viel anders, als im Berliner Innenbereich, wo jede Baulücke geschlossen wurde, die Parks totgefeiert werden und die Verkehrs- und Agressionsdichte sehr hoch ist.

- Ich habe viel mehr Ausländer gesehen, als ich erwartet hatte. Da hat sich in den letzten Jahren offensichtlich einiges geändert. Die Anzahl der Menschen, die offensichtlich von sehr wenig Geld leben müssen, kam mir auch sehr hoch vor.

- Interessant, aber auch, was ich NICHT vorgefunden habe: Penner, Graffitis, Scherben auf den Fußwegen und ramponierte Grünanlagen. Man spürt die Bemühungen, den Ort in Ordnung zu halten. Die Gebäude sind saniert, die Wege sauber, die Marzahner Promenade wird neu gestaltet.

- Marzahn ist von Prenzlauer Berg gerade mal 10 Km entfernt, und trotzdem war ich von dem Ort überrascht. Dort wohnen viele Menschen, die sich die Innenstadt nicht mehr leisten können. Weniger Geld bedeutet aber eben nicht zwangsweise Ghetto.

Stammeszugehörigkeit statt Nationalität

Ich fragte mich, wie es sein kann, dass ich mich einem 9000 Km entfernten Stadtteil einer US Großstadt emotional näher fühle, als einem 10 Km entfernten Ortsteil meiner eigenen Stadt?

In Marzahn fiel mir spontan der Begriff „Parallelgesellschaft“ ein. Und mir wurde klar, dass die Parallelgesellschaft nicht in Marzahn wohnt, sondern in Prenzlauer Berg.

Ich bin selbst die Parallelgesellschaft.

Und plötzlich machen viele Dinge Sinn, über die ich mich stets etwas gewundert hatte:

Damals in San Francisco hatte ich das vage Gefühl, einem geheimen Stamm anzugehören, der sich kaum über die geographische und kulturelle Herkunft definiert, sondern sich sein Wertesystem gerade selber zusammenbastelt. Mir fiel der alte Spontispruch ein, dass die wahren Grenzen nicht zwischen den Völkern verlaufen, sondern zwischen oben und unten. Aber ich war weder oben noch unten, sondern irgendwie parallel daneben.

Ich war verblüfft, wieviele Menschen in Europa nicht nur den Euro abschaffen, sondern auch wieder Grenzkontrollen einführen wollen. Sicherlich ist vieles in der EU reformbedürftig, aber genau die Reise- und Niederlassungsfreiheit und die gemeinsame Währung habe ich immer als einen der wichtigsten Erfolge der 90er Jahre gesehen. Es war mir völlig unverständlich, wie man dagegen sein kann.

Ganz klar: Wir haben völlig unterschiedliche Perspektiven.

Ich habe selber schon mal ein paar Monate im Ausland gearbeitet, war immer mobil. Ging ja nicht anders, wenn man einen halbwegs vernünftigen Job haben wollte. In meinem Freundes- und Bekanntenkreis sieht es nicht viel anders aus: Drei Personen sind in den letzten Jahren nach Australien ausgewandert, einer nach Argentinien, drei nach Kalifornien. Eine Bekannte hat drei Jahre in Saudi-Arabien gearbeitet, bevor sie in die Schweiz gezogen ist und eine Person hat bereits in Marseille und Rio de Janeiro gewohnt, bevor sie nach Deutschland zurück kam.

Das hängt natürlich auch vom Beruf ab. IT, Medien, Management, Kunst,…

Ich habe Bekannte, die in Nordfinnland wohnen. Ab und an trifft man sich mal in Berlin oder eben dort oben. Das ist für mich so normal, dass ich gar nicht mehr darüber nachgedacht habe.

Aus meiner Perspektive ist jede Grenze und alles was meine Mobilität behindert schlecht.

Kontrollverlust und fremde Werte

Die breite Masse mit normalen Jobs (Verkäufer, KFZ-Mechaniker, Friseur, Verwaltungsangestellte, …) ist bei weitem nicht so mobil. Die fliegen vielleicht einmal im Jahr für zwei Wochen nach Mallorca, falls sie es sich leisten können.

Deren Perspektive ist nicht, dass sie selber mobil sein wollen, sondern dass von überall her Leute kommen, die sie nicht eingeladen haben. Gleichzeitig sind immer mehr Arbeitsplätze ins Ausland verlagert worden. Die Menschen sind damit einfach überfordert und fühlen sich überrollt.

- Sie protestieren dagegen, dass normale Arbeit vollkommen entwertet wurde.

- Sie protestieren dagegen, dass ihre Werte nicht mehr respektiert werden.

- Sie protestieren dagegen, dass ihnen auf arrogante Art ständig andere Werte aufgezwungen werden sollen: Flexibilität statt Sicherheit, Weltoffenheit statt Bodenständigkeit, veganes Essen statt leckerem Schweinebraten, Radfahren statt einem schicken Auto, Urbanität statt Häuschen im Grünen, usw.

- Sie protestieren eigentlich nicht gegen die offenen Grenzen, sondern gegen den eigenen Kontrollverlust.

Und das kann ich sehr gut verstehen.

Und unsere Führungskräfte müssen das auch verstehen – und zwar ziemlich schnell. Wir brauchen bedachte Kurskorrekturen, bevor die Gegenbewegung eine Dynamik annimmt, die mehr kaputt macht, als wir und vorzustellen wagen. Das gilt für Deutschland genauso, wie für die USA, Großbritannien, Frankreich und eigentlich alle westlichen Länder.

Ich möchte hier noch auf einen Artikel im Tagesspiegel verweisen, der ähnlich argumentiert: „Eine andere Welt ist möglich – aber als Drohung„

Dirk Ollmetzer | Sonntag, 30 Oktober 2016 |

Gizmos,

RetroWenn man sich wie ich schon in den frühen 80er Jahren mit Heimcomputern beschäftigt hat, gehört man bereits zu den Veteranen des Digitalzeitalters. Dennoch ist mir in den letzten Jahren immer stärker klar geworden, dass ich kaum Ahnung von den Rechnern habe, die vor dieser Zeit im Einsatz waren. Das hat natürlich auch damit zu tun, dass es nicht allzuviele Geräte aus der Computerfrühzeit gibt. Die Stückzahlen waren damals noch sehr gering und es haben auch nicht viele Maschinen überlebt, weil es extrem aufwändig ist, solch alte Geräte lauffähig zu halten.

Als ich auf dem Vintage Computing Festival 2014 endlich zwei der legendären Computer der Firma Digital Equipment in Natura im Betrieb sehen konnte, war ich daher schwer fasziniert. Es wurden damals eine sehr stylische 12-Bit PDP-8/e aus dem Jahr 1970 mit VT-05 Videoterminal und die 16-Bit PDP-11/34 aus dem Jahr 1976 mit Teletype 33 ASR Terminal vorgeführt.

Damals war auch schon Oscar Vermeulen dabei, der einen Bausatz für eine Mini-Replika der PDP-8/i entwickelt hatte. Das Gerät sieht fast genauso aus, wie das Original, ist allerdings erheblich kleiner und hat einen sehr hohen Niedlichkeitsfaktor. Die Bedienung ist tatsächlich genauso, wie beim Original und man kann natürlich die alte Software aus den 60er und 70er Jahren laufen lassen. Beim diesjährigen VCFB habe ich mich dann endlich dazu durchgerungen, Oscar einen dieser mittlerweile weiterentwickelten Bausätze abzukaufen – für den Nerd-Preis von 2 hoch 7 Euro (€128).

Vier Wochen später ist es soweit: Meine PiDP-8 läuft und ich habe die ersten Stolperschritte im Betriebssystem OS/8 gemacht. Die Ein- und Ausgabe auf einem Laptop erfolgt stilecht über Cool-Retro-Term im Look eines VT-05 Terminals.

PiPD-8 mit Terminal

Weshalb der Name PiDP-8 anstatt PDP-8? Der Bausatz ist eigentlich gar kein Computer, sondern nur „Blinkenlights“ – also das Frontpanel mit LEDs und Eingabetastern. Dazu wird noch ein Raspberry Pi benötigt, auf dem die Software SimH läuft, die die eigentliche Rechneremulation ausführt. Trotzdem bleibt noch genügend Bastelei übrig.

Zunächst sollte mal den Raspberry Pi und die Software vorbereiten. Dazu benötigt man den Raspberry Pi, eine Micro SD Karte, einen SD-Karten Adapter, einen USB Speicherstick, einen Computer mit SD-Karten Steckplatz, ein USB Ladegerät, eine Tastatur, eine Maus und einen Bildschirm. Ich habe den Raspberry Pi einfach per HDMI an den Fernseher angeschlossen. Wenn alles läuft, braucht man Tastatur, Maus und Bildschirm nicht mehr.

Raspberry Pi vorbereiten

Auf der PiPD-8 Homepage werden zwei Varianten beschrieben, wie man die Software zum Laufen bekommt. Variante 1 ist das Image einer fertigen PDP-8 Distribution und in Variante 2 wird die Software auf einer normalen Raspbian Dsitribution installiert.

Empfehlen kann ich nur Variante 2. So benötigt der Rechner zwar 30 Sekunden anstatt 10 Sekunden zum Starten, lässt sich aber wie gewohnt einrichten und anpassen. Bei der Fertigdistribution hatte ich Probleme mit Tastatur, Netzwerk und Systemaktualisierung.

Nachdem die PDP-8 Emulation läuft, kann man sich an das Basteln der Hardware machen. Dazu benötigt man neben dem Bausatz vor allem Lötkolben, Lötzinn, Seitenschneider und für das Gehäuse Bohrmaschine, Laubsäge, Feile und feine Kreuzschlitzschraubendreher.

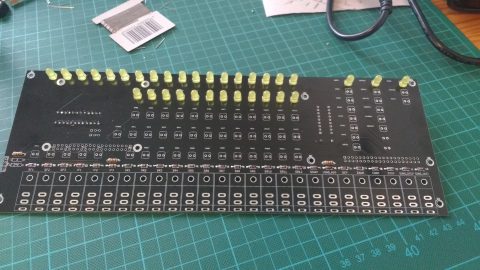

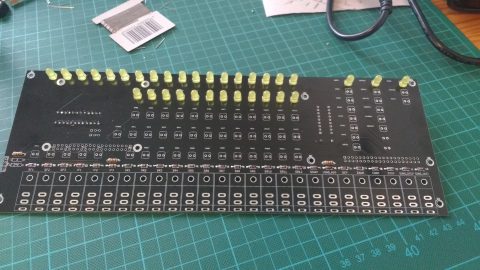

Fertig zum Löten

Wichtig ist, die Anweisung genau zu lesen. Es gibt einige typische Stolperfallen, in die man sonst leicht tappen kann:

Vorder- und Rückseite des Boards verwechseln, Dioden und LED mit falscher Polung oder Sockelleisten falsch einlöten, Schaltertypen verwechseln usw..

Davon abgesehen ist der Bausatz einfach, und auch für einen Hardwarelegastheniker wie mich machbar.

Tip: Achtet auf richtiges Werkzeug. Ich habe mir extra einen neuen Lötkolben mit feiner Spitze besorgt. Der auf dem Foto gezeigte war wenig geeignet.

Tag 1: Dioden, Widerstände und erste LEDs sitzen

Wenn man vernünftiges Wekzeug hat, jedes Teil dorthin setzt, wo es hin muss, man auf die kleinen Stolperfallen achtet und Lötbrücken und kalte Lötstellen vermeidet, kann eigentlich nichts schief gehen. Der Rest ist Fleißarbeit: für 26 Dioden, 15 Widerstände, 89 LEDS, einen IC Sockel, eine Stiftleiste und 26 Schalter braucht man schon ein wenig Zeit. Ich habe das Board an drei Tagen zusammengelötet.

Tip: Zwischendurch immer mal prüfen, ob die LED und die Schalter gerade sitzen, indem man das Board hinter das Frontpanel hält

Tag 3: Das PiDP8 Board ist fertig

Nachdem ich das Board fertiggebaut und den Raspberry Pi auf der Rückseite montiert hatte, lief zu meiner großen Freude alles ohne Probleme. Damit hatte ich eigentlich gar nicht gerechnet.

Ich hatte allerdings auch nicht damit gerechnet, dass die größten Schwierigkeiten beim Einbau des Rechners in die Bambusholzkiste auftreten würden. Als ich das Loch an der linken Gehäuseseite für Ethernet und USB heraussägte, splitterte der Bambus, die große Holzleiste hinter den Schaltern ließ sich nicht mit den 9,5mm Schrauben befestigen, weil diese nicht in das Montageloch unter den Schaltern eingeführt werden konnte und fast alle Micro-USB Kabel, die man für die Stromversorgung braucht, waren zu lang und unflexibel um in die Kiste eingebaut werden zu können. Ein Kabel, das oben aus der Kiste herausragt, wollte ich aber nicht haben.

Aber wenn man schon mal so weit ist, lässt man sich von solchen Kleinigkeiten nicht aufhalten. Der Rechner sitzt jetzt im Gehäuse und sieht aus, wie ich ihn mir vorgestellt hatte. Jetzt kann ich mich durch fast 50 Jahre alte Dokumentation bei Bitsavers durchwühlen, um den Umgang mit der Maschine zu lernen. Und nächstes Jahr baue ich dann die PiDP-11/70… :-D

PiDP-8: fertig und läuft

Hinter mir liegt ein verlängertes Wochenende in Hannover, das mir sehr viel Spaß gemacht hat. Ich möchte den Menschen danken, die dazu beigetragen haben (in chronologischer Reihenfolge):

Maike, Uwe, Melanie, Olaf und Bernd, den ich nach dem Konzert kennenlernen durfte.

Es gab nette und interessante Gespräche, lecker Kaffee und Kuchen in der Menagerie, ordentliche Mengen Newcastle Brown Ale im Jack the Ripper’s, erstaunlich leckere „zwischendurch Pizza“ in Oberricklingen, plötzlich richtig gutes Wetter, als wir auf der Driving Range in Gleidingen waren und natürlich den Anlass meiner kleinen Reise: Das rappelvolle Konzert der Dead Kennedys im Kulturzentrum Faust.

Obwohl es nicht mehr ganz die Originalbesetzung war und die Zuschauer (wie ich) so langsam aufs Seniorenalter zugehen, ging die Post ganz gut ab. Zum Abschluss gab es dann noch einen Absacker im Izarro.

Heute Morgen in der Markthalle noch ein paar regionale Spezialitäten geholt und danach ging es zurück nach Berlin.

Und jetzt könnte ich gut ein Wochenende gebrauchen um auszuspannen…

Morgens in der List

Mittags auf dem Golfplatz

Abends Old-Boys-Punk

Der Tag der Deutschen Einheit hat uns Anfang Oktober zu einem langen Wochenende verholfen, das Wetter schwenkte aber nun endgültig in Richtung Herbst.

In Berlin gab es für Nerds zwei Veranstaltungen, an denen man sich die Zeit vertreiben konnte: Die Maker Faire hatte ihre Publikumstage am Samstag und Sonntag und das Vintage Computing Festival am Sonntag und Montag.

Maker Faire Berlin 2016

Die Veranstaltung fand in der Station am Gleisdreieck statt. Ich besuchte sie zum ersten Mal und ich wusste im Vorfeld noch nicht so recht, was ich davon halten sollte, obwohl ich natürlich das Eine oder Andere im Vorfeld gelesen hatte.

Maker Faire in der Station Berlin

Gut besucht

In zwei Hallen ging es im Prinzip darum, Leute fürs Selbermachen zu interessieren, inspirieren und zum Kauf von entsprechenden Materialien und Werkzeugen zu bewegen. Es gab Stände, die handwerkliche Dinge zeigten, wie Bootsbau mit selbstgebogenen Hölzern, textiles Gestalten, Ringe schmieden usw. Der Schwerpunkt lag aber auf elektronischen Basteleien, 3D Druck, Lasercutter und Robotik.

R2-D2 in Aktion

Der R2-D2 Builders Club zeigte mehrere, sehr realistisch anmutende „Androiden“, teilweise in Aktion und in verschiedenen Montagestufen. Dennoch kann man hier eigentlich nicht von Robotern sprechen, da es sich am Ende doch „nur“ um ferngesteuerte Robotermodelle handelt.

Nao Roboter

Der knapp 60cm große Nao von Aldebaran Robotics ist hingegen ein echter autonomer, humanoider Roboter. Er war massenweise auf der Maker Faire vertreten, weil hier mehrere Mannschaften im Robo-Cup gegeneinander antraten.

Robocup

Man konnte hier einen netten Nachmittag verbringen, wobei ich die eigenartige Kombination aus „wir zeigen mal, was wir tolles machen“, „probier mal selber“ und „hier kannst Du Werkzeug und Material kaufen“ immer noch seltsam finde. Da ich regelmäßig thematisch entsprechende Websites (Hackaday, Adafruit, Make:,…) besuche, hat mich allerdings inhaltlich nichts wirklich überrascht.

Familien, die ihre Kinder spielerisch an den Umgang mit Technik und vor allem an die Idee heranführen wollen, dass man Dinge auch selber bauen kann, anstatt sie fertig zu kaufen, sind hier richtig gewesen.

Vintage Computing Festival 2016

Wie auch schon in den letzten Jahren fand im Pergamon Palais der Humboldt Universität Berlin das Vintage Computing Festival statt. Es gab auch in diesem Jahr wieder Vortäge, viele interessante Exponate, einen Game Room, in dem Spiele auf diversen alten Videospielen und Computern gespielt werden konnten und eine Party mit Chiptunes.

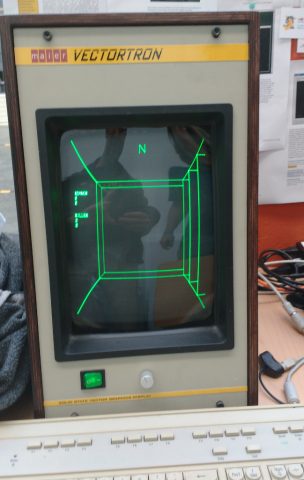

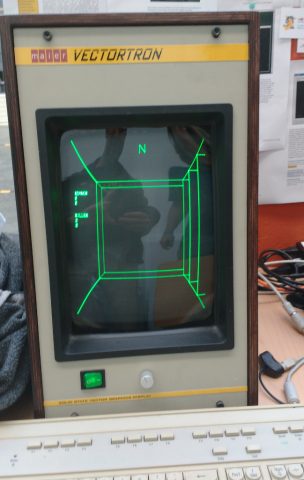

Die gezeigte Hardware fand ich im Vergleich zu den Veranstaltungen in den letzten Jahren vom Umfang insgesamt etwas schwächer, obwohl auch wieder einige originelle Highlights gezeigt wurden. Beispielhaft sei ein selbstgebautes Vectordisplay genannt, auf dem man u.a. Mazewar (einem Multiplayer, First Person Shooter aus dem Jahr 1974!) und das Vectrex Spiel Minestorm bewundern konnte.

MazeWar auf selbstgebautem Vectordisplay

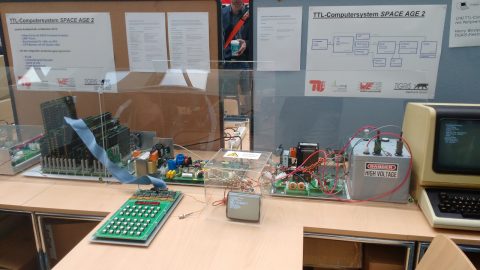

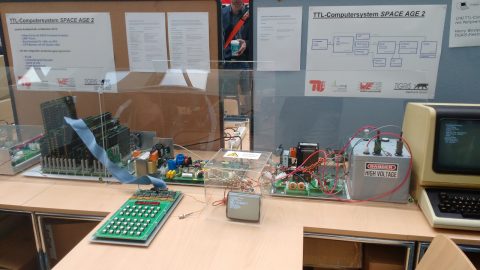

Die TU Berlin war ebenfalls wie in den letzten Jahren mit selbstgebauter Hardware vertreten: Diesmal mit dem Space Age II, einem 32-Bit-Computer, dessen CPU aus 490 TTL-Bausteinen aufgebaut ist und eine MIPS 1 kompatiblen Befehlssatz unterstützt.

Space Age 2 TTL Computer

Für mich waren in diesem Jahr die Vorträge interessanter. An der „Kurztagung „Hello, I’m ELIZA.“ – Zum 50. Geburtstag eines Chatbots“ habe ich leider nicht teilgenommen. Das war insofern schade, als Chatbots ja momentan von den großen Treibern aus den USA (Google, Facebook, Amazon, Apple, Microsoft,…) zum „next big thing“ hochgepusht werden. Ich bleibe da eher etwas skeptisch.

Sehr beeindruckt hat mich der Vortrag „Spracherkennung mit dem Z9001„, in Volker Pohlers zeigte, wie in den 80er Jahren in der DDR mit unglaublich geringen Mitteln eine rudimentäre Sprachsteuerung (50 gesprochene Befehle) entwickelt wurde.

Wolfgang Stief führte seine interessante Vortragsreihe über den „Vater des Supercomputings“ unter dem Titel „Defining Supercomputing – Seymour Cray und die CDC 6600“ weiter. Zu der etwas desolaten Raumsituation der Großcomputersammlung Sammlung in München gab es leider nichts Neues. Die Halle ist noch immer gesperrt und der Ersatz nicht fertiggestellt.

Aber auch die robuste 8-Bit Technik der 70er Jahre wurde wieder ausführlich behandelt. Hans Franke referierte nach etwas holperigem Start über Vor- und Nachteile der Speicherorganisation typischer 8-Bit Computer.

Dr. Frederik Holst erzählte in seinem Vortrag „Die inneren Werte zählen – Perspektiven- und Paradigmenwechsel beim Übergang von Hoch- zu Maschinensprache“ von seinen Schwierigkeiten, Maschinensprache zu lernen. Hochsprachen sind problemnah (z.B. „Zeichne ein Kreis auf den Grafikbildschirm“), was sie zunächst verständlicher macht, obwohl es viele unterschiedliche Befehle gibt. Maschinensprache hat im Vergleich dazu nur sehr wenige Befehle (z.B. „Schreibe Wert X in Speicherstelle Y“). Allerdings muss man die Hardwarearchitektur des Rechners bis ins Detail verstehen und sich selber um jedes winzige Detail kümmern. Es ist also eine vollkommen andere Sicht auf das Problem und den Computer nötig.

Ich hatte noch eine Diskussion mit Wolfgang Stief zum Thema Software auf Großrechnern. Zwar ist es fantastisch, dass sich Menschen finden, die die alten Rechendinosaurier funktionsfähig halten, aber mir fehlen die Anwendungen. Wie will man den Sinn und Zweck der alten Technik demonstrieren?

Während es für die alten Heimcomputer massenhaft Spiele gibt, die katalogisiert und gesammelt werden, und die für die ersten PCs typischen Softwarepakete, wie Wordstar und Visicalc (trotz der rechtlich problematischen Situation) verfügbar sind habe ich noch keine Software für Grossrechner gesehen. Wo sind die Buchhaltungs- und Bankprogramme? Wo ist Software zur Wettervorhersage und zu Crashtests? Hier hat die Medienarchäologie noch ein weites Feld zu beackern.

Der VCFB hat für mich ein wenig den Charakter eines Klassentreffens. Einerseits, weil man mittlerweisle viele der Aktiven kennt, andererseits auch wegen dem robusten Do-it-yourself Charme der Veranstaltung. Dabei meine ich ausdrücklich nur das Ambiente, denn was der Fachbereichs Medienwissenschaften der HU Berlin zusammen mit dem Hackerspace AFRA und der technischen Unterstützung des Chaos Computer Clubs hier seit Jahren auf die Beine stellt ist bemerkenswert professionell organisiert. Leider fand das VFCB in diesem Jahr zum letzten Mal in den Räumen der Humboldt Universität statt. Im nächsten Jahr wird dafür das Technikmuseum Berlin Räumlichkeiten auf seinem Gelände am Gleisdreieck zur Verfügung stellen. Man darf gespannt sein.

Dirk Ollmetzer | Sonntag, 28 August 2016 |

Gizmos,

RetroWährend manche Leute riesengroße Touchscreens in Autos wie dem Tesla Model S für tollen modernen Kram halten, sind andere Branchen schon wieder ein paar Jährchen weiter. In Bereichen, die bereits seit Jahren oder Jahrzehnten digitalisiert sind und wo es für die Nutzer auf schnelle und intuitive Bedienung ankommt, sind digitale Benutzeroberflächen schon längst wieder auf dem Rückzug, weil sie zu sperrig in der Bedienung sind.

Ein Beispiel sind Musikinstrumente. Der Siegeszug der digitalen Klangerzeugung bei Synthesizern in den 80er und 90er Jahren führte zu Benutzeroberflächen mit Displays und wenigen Knöpfen. Aktuelle Modelle dagegen strotzen wieder vor Drehknöpfen und Schiebereglern, die den Musikern eine virtuose, „blinde“ Bedienung überhaupt erst ermöglichen.

Digitale Technik ist toll, digitale Bedienung aber nicht

Ein anderes Beispiel sind Fotoapparate. Auch hier gibt es einen Trend zurück, den manche als Retrowelle missverstehen. Ich hatte mir vor fünf Jahren eine spiegellose Systemkamera im Micro-Four-Thirds Standard gekauft: Eine Panasonic Lumix DMC-GF2. Ausschlaggebend waren gute technische Werte, hohe Bildqualität, gute Verarbeitung und ein Standard, der von mehr als einem Hersteller unterstützt wird zu einem attraktiven Preis.

Allerdings sind wir nie so richtig miteinander warm geworden. Die Kamera hat zwar 1000 Möglichkeiten, die sind aber alle irgendwo in -zig Untermenüs verteilt. Wenn man etwas verstellen will, muss man auf das Display gucken. In der Zeit ist dann das Motiv weg. Das hat dazu geführt, dass ich eigentlich nur im Automatikmodus fotografiert habe. So eine Kamera holt man sich aber eigentlich nicht nur zum „knipsen“.

Bei meinem Besuch auf der Festung Suomenlinna bei Helsinki ist mir 2013 eine komplette Fotoserie durch einen verstellten Weißabgleich unrettbar verlorengegangen. Irgendwie war ich aus Versehen in das Menü gekommen und hatte die falsche Grundeinstellung nicht mehr bemerkt. Danach war ich so verstimmt, dass ich die Kamera nicht mehr angefasst habe.

Die analogste Digitalkamera, die ich je angefasst habe

Vor ungefähr einem halben Jahr bin ich ziellos durch ein Geschäft geschlendert und habe dabei die Olympus OM-D E-M 10 Mark II entdeckt. Ich habe sie spontan in die Hand genommen, weil sie so niedlich und Retro aussah. Ungefähr wie eine Olympus OM aus den 70ern und 80ern – bloß viel kleiner. Interessanterweise ist das ebenfalls eine Micro-Four-Thirds Kamera und somit systemkompatibel zur Panasonic mit vergleichbaren technischen Eckwertern.

Olympus OM-D E-M 10 Mark II

Mein Interesse war geweckt, ich habe Tests gelesen, Beispielfotos angesehen und das Teil noch ein paar mal in die Hand genommen. Nach langem hin- und her habe ich sie nun in einem Berliner Fachgeschäft gekauft.

Nicht weil sie niedlich ist, sondern weil sie sich unheimlich gut bedienen lässt.

Bei der Olympus lässt sich alles Wichtige mit den drei Rändelrädern extrem schnell und vor allem blind einstellen. Zudem hat sie zusätzlich zum normalen Display auf der Rückseite einen sehr guten elektronischen Sucher. Die Raterei, was man eigentlich aufnimmt, während von hinten die Sonne auf das Display fällt, ist mit diesem Gerät jedenfalls kein Problem. Das Spiel mit Schärfentiefe, Belichtungsspielereien, wie Bewegungsunschärfe usw. klappten nach wenigen Minuten, ohne das Handbuch bemühen zu müssen. Das ist insofern praktisch, als auch gar kein richtiges Handbuch in der Packung lag, sondern nur ein Schnelleinstieg in ca. 725 Sprachen.

Keine Besserwisserei des Geräts

Ein weiterer Vorteil gegenüber der Panasonic ist, dass die Olympus nichts automatisch und ungefragt wegkorrigiert. Zwei Beispiele:

- Wenn man mit der Panasonic versucht hat ein Portrait aufzunehmen, war es nahezu unmöglich die Tiefenunschärfe einzustellen um den Hintergrund unscharf zu bekommen, weil auf dem Display einfach das komplette Bild scharfgerechnet angezeigt wurde. Die Olympus zeigt die Tiefenunschärfe im Display richtig an.

- Das Aufnehmen von tollen Farben von Himmel und Wolken bei Sonnenuntergang hat mit der Panasonic regelmässig nicht geklappt, weil eine automatische Helligkeitskorrektur alles auf 60% Standardbelichtung „korrigiert“ hat. Mit der Olympus hat das hingegen bereits im Automatikmodus gut funktioniert. Und eine Belichtungsreihe mit Blendenautomatik war in 10 Sekunden im Kasten.

Fazit: Nix mit Retro – digitale Technik und analoge Bedienung ist die ideale Kombination

Bei beiden Kameras sind die technischen Eckdaten aufgrund des gemeinsamen Micro-Four-Thirds Standards vergleichbar: Gleiche Sensorfläche, 16MP Bildqualität usw. Aber in der Bedienung liegen Welten zwischen den beiden Kameras:

Auf der einen Seite die Panasonic GF2: Ein Touchscreen Computer mit angebautem Objektiv, der die kreative Arbeit am Bild nicht nur nicht unterstützt, sondern sogar behindert oder gar besser als der Nutzer wissen will, wie das Bild auszusehen hat. Im Prinzip ist das eine Automatikknipse. Dafür ist der Spass aber viel zu kompliziert und teuer, weil man diese Art Bilder mittlerweile auch mit einem guten Smartphone hinbekommt.

Auf der anderen Seite die Olympus: Mein erster, spontaner Eindruck war falsch. Das ist kein Retromodell, sondern ein echter Fotoapparat, der einem schnelle und unkomplizierte Bildgestaltung ermöglicht, sofern man sich mit den Grundlagen der Fotografie ein wenig auskennt. So muss es sein.

Hier sind ein paar Probefotos:

Modellboot auf dem Weissensee

Harte Licht/Schatten-Kontraste, Vordergrund, Mittelgrund, Hintergrund, Fokus auf dem Modellboot. Blätter im Vordergrund nicht zu dunkel, MIlchhäuschen überstrahlt nicht.

Brennweite 42mm (84mm KB), Blende f/10,0, Belichtungszeit 1/320s, Empfindlichkeit ISO 200.

Baumstumpf

Graues Motiv vor grauem Hintergrund im Schatten.

Brennweite 19mm (38mm KB), Blende f/5,6, Belichtungszeit 1/125 Sek., Empfindlichkeit ISO 200.

Baumstumpf Detail

Abendlicht

Abendstimmung, verschiedene Lichtquellen (Himmel, Strassenlaternen, Autoscheinwerfer). Die Farben sind stimmig bei leichtem Überstrahlen des Himmels.

Brennweite 14mm (28mm KB), Blende f/2,5, Belichtungszeit 1/15 sek., Empfindlichkeit 1600 ISO

Damals in der 80ern waren nicht nur die Heimcomputer neu, sondern auch diverse Zukunftsszenarien aus damals aktuellen Science-Fiction Geschichten. Ganz heiß erschien damals die Idee vom Cyberspace, oft auch Virtual Reality (VR) genannt. Eine völlig künstliche Umgebung, die nicht den Zwängen der realen, körperlichen Welt unterlag. Eine konstruierte Welt aus Software, in der man sich scheinbar grenzenlos bewegen konnte. Unendliche Möglichkeiten schienen sich aufzutun…

Die ersten wirklichen Versuche, VR umzusetzen waren in den 90ern dagegen ziemlich ernüchternd. Und zwar so sehr, dass das Thema – bis auf Nischenanwendungen, wie Automobildesign – eigentlich seit 20 Jahren vom Tisch ist.

In den letzten 1-2 Jahren kocht das Thema aber so langsam wieder hoch. Ich muss zugeben, daß mich das ziemlich kalt lässt. Als Jugendlicher wäre ich damals vermutlich völlig drauf abgefahren, aber mir ist die Idee mittlerweile einfach zu abgedroschen.

Trotzdem kann natürlich ein kleiner Reality-Check nicht schaden. Versuchen wir mal die Einsteigerdroge: Google Cardboard.

Let’s do it!

Ich hatte mir vor drei oder vier Monaten schon mal Google Cardboard auf meinem Smartphone installiert, aber ohne VR-Brillengestell machte das keinen Sinn. Also hatte ich die App erstmal wieder gelöscht. Am Samstag bin ich bei Conrad über einen Stapel VR-Brillen von Google gestolpert. Kostet ja nicht sooo viel, also habe ich eine der Pappschachteln mitgenommen.

Google Cardboard

Fertig zum Aufsetzen

Das Prinzip ist simpel: Eine Pappschachtel mit zwei Linsen, in die man sein Smartphone klemmt, das ganze auf die Nase setzt und mit den Halteriemchen am Kopf fixiert.

Aber vorher musste ich die App neu installieren, weil ich sie ja zwischenzeitlich gelöscht hatte und – oh Wunder – mein Telefon ist plötzlich nicht mehr kompatibel. Wieso? Vor drei Monaten ging es doch. Ich habe Android 6 auf dem Phone – von veraltet kann also keine Rede sein. Nun gut, also habe ich mit ein paar andere VR-Apps heruntergeladen und damit etwas rumgespielt.

Fazit

Die Erfahrung kann ich in einem Wort zusammenfassen:

Schrott!

Oder etwas ausführlicher:

- Man sieht wie der letzte Mutant aus. Smombies sind ein Scheissdreck dagegen.

- Die Kiste mit dem Smartphone auf der Nase nervt – es ist zu schwer und stört einfach nur.

- Die Fokussierung stellt sich auch nicht gerade von selbst ein. Ich musste mich ziemlich konzentrieren.

- Keine der Apps hat den Gyroskop im Telefon richtig benutzt. ein Kopfschwenk führte meistens zu gar nichts oder zu einer verzögerten Bewegung, die überhaupt nicht synchron zur Körperbewegung.

- Die Bedienung ist problematisch, weil man den Touchscreen ja nicht mehr anfassen kann.

- Dadurch, dass man mit den Augen direkt am Display ist, wirkt das Bild ist unglaublich grobkörnig. Ohne 4K-Display braucht man so etwas gar nicht anzufangen.

- Von dem Fake-3D wird mir innerhalb von 30 Sekunden übel.

- Es gab keine einzige App, die mich inhaltlich irgendwie interessiert hätte.

Gut, einige der Punkte davon könnte man mit richtiger Hard- und Software korrigieren. Aber eine wesentlich teurere Kombination aus High-End Samsung Phone und der dazugehörigen Brille war auch nicht viel besser.

Meiner Meinung nach ist die ganze VR-Idee – von einigen Spezialanwendungen wie Konstruktion oder Simulatoren mal abgesehen – für die breite Masse unsinnig.

Und überhaupt…

Daß so beharrlich versucht wird, diese eigentlich schon begrabene Idee wieder aufzuwärmen, hinterlässt bei mir einen faden Beigeschmack. Virtual Reality reiht sich für mich in eine täglich länger werdende List von technischem Zeug, dass ich explizit nicht haben will, wie z.B.:

Internetfähiger Kühlschrank. Die Idee war vor 20 Jahren Schrott, vor 10 Jahren Schrott, ist immer noch Schrott und bleibt es auch.

Chatbots. Noch so ein 20 Jahre alter aufgewärmter Quark. Was soll toll daran sein, mit begriffsstutzigen Maschinen zu reden? Das nervt ja bei Menschen schon genug.

Smarthomes und überhaupt alles, was gerade mit „Smart-“ anfängt. Damit absolut jeder Lebensbereich ausgeforscht und im nächsten Schritt ferngesteuert werden kann. Und wir entwickeln uns alle im Rekordtempo zurück zu Amöben. Einige sind ja schon recht weit auf diesem Weg…

Internet of Things. Super, dass jetzt nicht nur mein Computer und mein Handy, sondern auch Lampen, Stereoanlagen, Heizungen, Blumenvasen und Bilderrahmen tägliche Securityupdates brauchen – und trotzdem gehackt werden. Das steigert so richtig die Lebensqualität.

Selbstfahrende Autos. Woher kommt diese Scheiß Idee eigentlich plötzlich? Ich habe in den letzten Jahren eigentlich niemanden gehört, der der Meinung ist, das größte Problem an Autos sei, dass man sie selber fahren muss. Eher so Umwelt, Platzverbrauch, Lärm, Zersiedlung der Landschaft, Ressourcen und ähnliche Dinge.

Eigentlich kann es doch nur darum gehen, so langsam wieder von den Autos wegzukommen und die restlichen mit erneuerbaren Energien anzutreiben.

Mobile Payment. Wenn mir das Handy geklaut wird, ist also nicht nur mein Telefon weg, meine Kontaktdaten, mein Kalender, meine Fotos, meine Social Media Zugänge kompromittiert, sondern auch noch das Geld, was ich auf dem Konto habe. Im Alltag bleibt das Standardproblem jeder bargeldlosen Finanztransaktion: die völlige Nachverfolgbarkeit jeder kleinen Zahlung. Ist ja ’ne Super Idee – ich bleibe bei Bargeld.

Künstliche Intelligenz. Seien wir doch mal ehrlich: Das werden alles absolut unerträgliche digitale Klugscheißer werden, die uns das Leben auf jede erdenkliche Art zur Hölle machen. Ist ja selten genug, dass man überhaupt mal natürliche Intelligenz endeckt.

Ich habe das Gefühl, dass diese dämlichen und ausgelutschten Ideen alle paar Jahre wieder rausgeholt werden, um zu prüfen, ob das Volk jetzt endlich verblödet und degeneriert genug ist um vollständig entmündigt zu werden. In anderen Gegenden der Welt wird dafür Religion verwendet und bei uns läuft es halt so.

Nach der glühenden Hitze der letzten Tage war es am Sonntag mit 24 Grad geradezu erfrischend. Ideale Voraussetzungen für eine schöne Landpartie. Also ab ins Auto, das Dach geöffnet und entspannt zum Schloss Wiepersdorf (ca. 80Km südlich von Berlin in der Nähe von Jüterbog) gefahren. Dort fand das jährliche Sommerfest statt.

Auf dem Sommerfest präsentieren die Stipendiaten in den Ateliers des Künstlerhauses ihre Arbeiten. Es gab Lesungen und Livemusik auf der Schlossterasse und sehr unterschiedliche Kunstwerke von koreanischen, finnischen und natürlich deutschen Künstlern in den Ateliers zu sehen.

Für das leibliche Wohl war ebenfalls gesorgt wie für interessante Gespräche mit Künstlern und Bekannten. So ging der wunderschöne Nachmittag auch schnell zu Ende. Aufgrund des EM-Fußballspiels waren die Straßen nahezu leer und daher sogar die Rückfahrt nach Berlin extrem locker.

Ein wunderschöner Tag!

Hier noch ein paar Impressionen:

Ortseingang Wiepersdorf

Schloss Wiepersdorf

Orangerie

Ausstellung Im Künstlerhaus

Dirk Ollmetzer | Dienstag, 3 Mai 2016 |

eCommerceDie Frage „Welche Shopsoftware würdest Du jetzt nehmen?“ stellte mir Lars Jankowfsky bei seinem Vortrag „E-Commerce was wirklich zählt. Die Developer Edition“ auf der code.talks eCommerce Konferenz. Zuvor hatte ich bereits erzählt, dass ich 2010 für die Shops der CBR eCommerce GmbH (siehe meine Referenzen) OXID Enterprise Edition ausgewählt hatte. Die wesentlichen Gründe waren damals, dass der Quellcode einsehbar war, die Verfügbarkeit von PHP Entwicklern und die bessere out-of-the-box Performance im Gegensatz zu Magento.

Seinerzeit ist das eine richtige Entscheidung gewesen. Aber was würde ich heute wählen?

Da kam ich ins schwimmen und sagte etwas lahm „Vielleicht eher Shopware“, aber die Antwort war nicht gut. Im Gegensatz zu 2010 ist die verfügbare Technik heute deutlich breiter aufgestellt, wie ja gerade auf dieser Konferenz deutlich wurde. Ehrlicherweise hätte ich sagen sollen, dass ich das neu evaluieren müsste.

Die eCommerce Technik wird immer differenzierter

Interessanterweise schien selbst Alexander Graf, der mit Spryker einer der Hauptsponsoren des Events war, etwas überrascht gewesen zu sein, welch breiten Raum das Thema Microservices auf der Konferenz einnahm. In seinem Artikel „Microservices & Einradfahren“ stellte er zunächst etwas verblüfft fest, dass es auch in der Welt der Techies so etwas wie Modetrends gibt, denen viele einfach hinterherlaufen. Er schrieb unter anderem:

„Zu meiner großen Enttäuschung muss ich nun feststellen, dass die Leute in der IT, bzw. Developer wie sie heute genannt werden, mit den gleichen Denkmustern arbeiten wie die Business Kasper [zu denen er sich selber zählt]. Es gibt eine extrem hohe Neigung Trends hinterherzulaufen und grundlegende technische Probleme nicht ausreichend bzw. nicht ehrlich genug zu analysieren.“

Für mich als Entwickler ist das natürlich überhaupt nichts Neues. Sehr viele Techies sind Diven mit aufgeblähtem Ego, die das Rad lieber zum 100. Mal neu erfinden – weil Ihr Rad natürlich viel viel schöner ist…

Der Rest des Artikels befasst sich damit, dass der Microservice-Ansatz gerade so ein angesagtes Ding ist, dass nicht ausreichend hinterfragt wird. Das Gefühl hatte ich allerdings nicht unbedingt. Für die vorgestellten Projekte gab es jede Menge gute Gründe, genau auf diese Architektur zu setzen – nur treffen die Gründe eben für die meisten „normalen“ Shops bei weitem nicht zu.

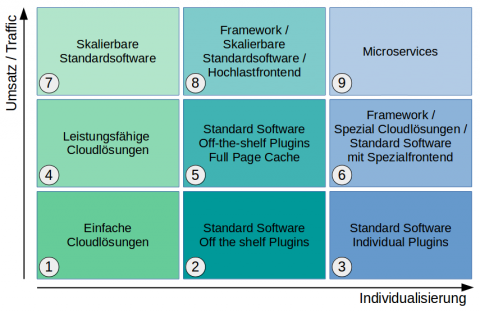

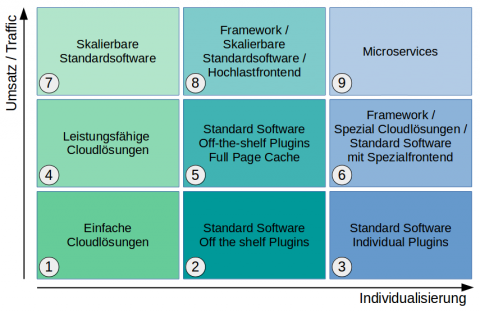

Orientierung zwischen Standard-Cloud und Microservices

Doch wie findet man die passende Technik in dem scheinbaren Wirrwar aus Cloudanbietern, Self Hosting, Out-of-the-box Software, Frameworks, Microservices usw?

Das hängt natürlich vom konkreten Projekt ab. Zwei wesentliche Kriterien zur Einordnung von eCommerce Projekten wurden bei der Konferenz für mich deutlich: Das Umsatzvolumen und der Grad der Individualisierung des Geschäftes. Ich habe mal für mich selber aus diesen beiden Kriterien eine Entscheidungsmatrix mit neun Feldern aufgezogen.

Kriterium 1: Das Umsatzvolumen

Bei geringem Umsatzvolumen ist eine einfachere technische Architektur ausreichend, dafür ist hier die Preissensibilität hoch. Bei sehr großen Umsätzen kann und muss man größere Ressourcen in die technische Skalierung stecken, hat aber dafür auch einen größeren Investitionsspielraum.

Kriterium 2: Grad der Individualisierung

Wer ein überschaubares Sortiment mit (datentechnisch) einfachen Produkten anbietet, kommt bereits mit Standardtechnik sehr weit. Je mehr Besonderheiten gefordert sind, desto mehr Aufwand muss in die Anpassung gesteckt werden. Beispiele sind konfigurierbare Produkte, Regionallager und Multichannel. Besondere Geschäftsmodelle, wie z.B. Shoppingclubs, zeitlich begrenztes Angebot, Auktionen etc. lassen sich eigentlich nur noch mit Individualentwicklungen umsetzen.

Die Entscheidungsmatrix

Das Ergebnis meiner Überlegungen ist diese Matrix, deren neun Felder ich kurz erläutere.

Entscheidungsmatrix

- Bei wenig Umsatz und Traffic können für Standardprozesse mit einem einfachen Sortiment bereits einfache und günstige Cloudlösungen gut geeignet sein.

Kandidaten wären hier ePages, Prestashop u.ä.

- Eine Anpassung an viele Besonderheiten kann bereits mit Standard Plugins für die üblichen Shopsysteme abgedeckt werden. Hier sollte aber ggf. bereits ein separates Hosting geplant werden, um in das System eingreifen zu können.

Geeignete Kandidaten sind u.a. Shopware, Oxid, Magento.

- Eine weiterreichende Individualisierung lässt sich bei geringem Umsatz eigentlich nur über Standardsoftware mit individuell erstellten Plugins realisieren, wenn man den Kostenrahmen nicht sprengen will.

Basistechnik entsprechend 2.

- Bei mittlerem Umsatz und Traffic sind für ein einfaches Sortiment und Standardprozesse leistungsfähige Cloudlösungen, wie Demandware gut geeignet.

- Bei mittlerer Komplexität und mittlerem Umsatz kann Standardsoftware (siehe 2.) mit Plugins und einem Full Page Cache eine solide Lösung sein.

- Bei mittlerem Umsatz und hoher Individualität ist eine Frameworkgestützte Individualentwicklung sicherlich nicht die schlechteste Wahl. Kandidaten wären hier Commercetools, Ongr. oder sogar Spryker, falls der Kostenrahmen das hergibt. Falls es zum Geschätsmodell passt sollte man auch NewStore auf die Shortlist nehmen.

- Standardanforderungen bei hohen Umsätzen kann man m.E. mit gut skalierbaren Systemen, wie Intershop oder Hybris in sorgfältig gebauten Systemsetups erfüllen

- Mittlere Komplexität bei hohen Umsätzen könnte mit leistungsfähiger Standardsoftware und einem individuellem Hochlastfrontend abbildbar sein, oder man greift gleich zu einer kompletten, frameworkgestützten Eigenentwicklung

- Und schließlich die Königsklasse: Hoher Umsatz, hohe Komplexität. Hier kommt man nicht mehr um eine Eigenentwicklung mit optimiertem Setup herum. Das ist genau das Feld, in sich dem Otto, Metro und Zalando tummeln (um jetzt mal nicht die rosa Elefanten Amazon und Alibaba zu nennen). Für diese Gewichtsklasse sind Microservice Architekturen sinnvoll. Für alle anderen Felder wären technische Komplexität und Kosten aber einfach zu hoch.

Mal kann jetzt natürlich zurecht fragen „was heißt denn klein, mittel und groß; Standard und komplex?“ Wo sind die Grenzen zwischen den aufgemalten Feldern? Zugegebenermaßen sind die Grenzen da fließend und man kann trefflich diskutieren. Trotzdem denke ich, dass man hier erst mal eine Idee und erste Struktur bekommt.

Aber um auf die Eingangsfrage von Lars zurückzukommen:

Heutzutage würde ich für das Projekt von 2010 vermutlich den Ansatz einer Standardsoftware mit vorgeschaltetem individuellem Hochlastfrontend wählen. So kann man schnell starten, das Geschäft gut hochskalieren und gleichzeitig individuelle Features umsetzen.

« Vorherige Seite — Nächste Seite »